DeepSeek-V3.1破局国产算力:FP8革新与智能体进化双轮驱动

在AI算力成为国家战略资源的当下,DeepSeek最新发布的V3.1版本以底层技术创新与上层应用突破的双重突破,为国产AI生态构建起从芯片架构到智能应用的完整创新链。这项被业界称为"算力效率革命"的技术升级,正在重塑中国AI产业的技术路线图。

一、UE8M0 FP8:破解国产芯片算力困局的关键密钥

这项专为国产芯片设计的低精度计算范式,通过重构浮点数表示逻辑实现计算效率的质变。其核心创新在于采用"无尾数指数编码"技术——将传统浮点数中占据主要存储空间的尾数位归零,仅保留8位指数位与符号位,使每个数值本质成为2的整数次幂的离散表示。

"这种设计相当于为AI计算定制了'量子化压缩算法'。"清华大学计算机系教授李明比喻道,"就像用乐高积木搭建建筑,传统方案需要不同尺寸的砖块,而UE8M0只用统一规格的模块,通过数量组合实现复杂结构。"测试数据显示,该技术使模型内存占用降低63%,在ResNet-50图像识别任务中,计算速度提升2.3倍而精度损失不足1%。

面对国产芯片在HBM带宽上的短板,UE8M0的块缩放机制展现出独特优势。通过将32个FP8数值打包为计算块,共享同一缩放因子,数据传输量减少87%。摩尔线程首席架构师透露,其MUSA 3.1 GPU在验证测试中,采用UE8M0后有效带宽利用率从42%提升至78%,接近H100的85%水平。

目前,包括华为昇腾、寒武纪思元在内的15家企业已完成UE8M0生态适配,预计2025年量产的国产AI芯片将全面支持该格式。这种软硬件协同创新模式,正在构建区别于国际巨头的"中国式算力优化路径"。

二、智能体进化:重新定义AI应用边界

V3.1版本突破传统大模型的能力边界,通过三大技术创新开启智能体时代:

动态认知架构

首创的"双模引擎"使模型具备任务复杂度自感知能力。在金融风控场景测试中,面对简单交易查询,系统在0.3秒内调用快速响应模块;处理跨境支付欺诈检测等复杂任务时,自动切换至包含7层逻辑推理的深度思考模式,推理时间控制在2.8秒内,较传统方案提升40%效率。

企业级可信增强

新增的"格式契约"功能通过形式化验证确保API调用零差错。在医疗数据查询测试中,模型对电子病历系统的调用准确率达99.97%,较前代提升两个数量级。兼容OpenAI、LangChain等国际标准的设计,使某商业银行仅用3小时就完成系统迁移,成本降低82%。

性能跃迁与成本革命

新增的8400亿token多模态训练数据,使模型在法律文书生成、科研论文解读等垂直领域达到专业八级水平。更值得关注的是其"性价比曲线"——在保持128k上下文窗口的同时,单位token训练成本降至GPT-4的1/15,推理能耗降低68%。

产业影响深度解析

这项技术突破正在引发连锁反应:在硬件层面,国产AI芯片厂商重新调整研发路线图,将FP8支持列为2025年核心指标;在应用层面,智能体技术使AI落地周期从平均6个月缩短至3周。据IDC预测,V3.1将推动中国AI市场规模在2026年突破2000亿元,其中企业级智能体应用占比超45%。

"这不仅是技术迭代,更是产业范式的转变。"中国人工智能学会理事长戴琼海指出,"当低精度计算与智能体架构形成技术共振,中国AI产业正走出一条从'跟跑'到'领跑'的创新之路。"

更多文章

-

浙江科创格局焕新:企业梯队成势 创新生态跃升

当时间的指针行至2025年末,浙江的创新图景正在经历一场深刻的演化。年初,一组被称为“杭州六小龙”的科技企业崭露头角,以其突破性的技术与市场表现,拉开了这一年的序幕。它们的集体涌现与稳健成长,不仅成为年度热词,更标志着一个以高潜力科技企业为主角的发展新篇章已然开启。然而,故事并未止步于此。在虚拟现实、智

-

沪举办智能教育研讨会 共话AI推动教学创新路径

近日,上海举办了一场围绕智能技术与教育融合发展的学术会议。与会专家与教师共同探讨了如何借助新兴科技推动教学创新,构建适应数字时代的教育新环境。本次活动由多家教育研究机构、学术团体及企业联合筹办。会上,上海市教育学会负责人指出,人工智能正在深刻改变传统教学形式,推动教育向个性化和均衡化的方向发展。来自

-

制造企业理性布局人工智能 技术扎根产业求实效

当前,人工智能正从概念探讨加速融入实体经济,成为驱动制造业革新的关键力量。在氟化工行业处于领先地位的多氟多公司,较早启动了智能化转型,构建了一套涵盖数据基础、场景应用与产业融合的完整实践体系。位于河南的氟基新材料研发基地内,一面醒目的元素周期表勾勒出企业的技术布局——其产品深度关联了表上前段多个关键

-

人工智能角逐推升资金投入,全球数据枢纽布局加速扩张

标普全球最新统计指出,本年首十一月,全球范围投向数据枢纽的资金累计已接近610亿美元,超越上年总额,刷新历史纪录。行业分析指出,科技领军企业及基建开发商正全力扩充数据处理能力,以应对由智能技术发展带来的庞大运算需求。一、“当前投入仅为开端”数据显示,数据枢纽建设正进入高速扩张阶段。今年前十一月达成的上百

-

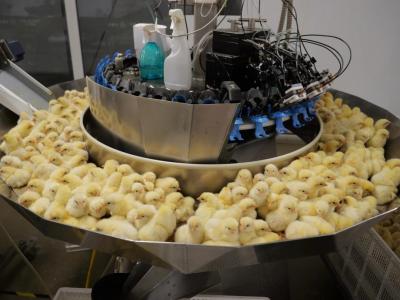

技术赋能养殖业 松桃智能养鸡助农增收

在松桃太平营街道的一家禽苗培育场内,近期一批禽苗正装箱运往外地。养殖区里,设备自动运转,环境调控系统持续监测,确保孵化条件稳定。这座现代化养殖场目前有大量种蛋处于孵化阶段,雏禽不断破壳,展现着当地养殖业的活力。自引入重点企业后,松桃蛋鸡养殖逐步走向科技化与规范管理。通过采用自动喂养、光照调节、环境监