华为突破性AI技术:实现十倍级上下文处理能力飞跃

华为于8月12日正式推出UCM推理记忆数据管理器,这项AI推理创新技术将重塑人工智能应用体验。该技术通过优化推理性能与成本效益,助力构建更可持续的AI商业生态。值得关注的是,华为已与中国银联达成合作,在金融领域率先落地UCM技术试点,并共同发布了智慧金融AI推理加速方案的首批应用成果。

随着人工智能技术进入深度发展阶段,推理环节的重要性日益凸显。华为数据存储产品线负责人指出:"在AI时代,Token数量已成为衡量模型效能的新标准。"当前行业面临的核心挑战在于,如何在保证推理质量的同时,实现算力资源的最优配置。这一技术突破,为破解效率与成本的平衡难题提供了创新解决方案。

华为最新研发的UCM推理优化系统由三大核心模块构成:跨平台推理引擎接口、智能缓存加速算法库以及高效数据存取适配器。这一创新架构通过整合计算框架、硬件资源和存储系统,显著提升了AI推理的经济性和实用性。

该系统的技术突破主要体现在两个方面:首先,采用智能缓存复用技术,通过直接调用历史计算结果,将初始响应延迟最高缩减90%;其次,创新性地实现了超长上下文的分层存储方案,通过外置专业存储设备扩展处理容量,使模型能够支持十倍于传统方案的文本长度,完美应对大篇幅内容处理需求。这种设计既保障了处理效率,又大幅降低了运算成本。

华为UCM系统通过创新的智能缓存管理机制,实现了显著的降本增效。系统能动态识别数据访问频率,在HBM高速缓存、内存和固态硬盘之间智能调度数据,配合优化的稀疏计算算法,使长文本处理效率提升2-22倍,大幅降低单次推理的算力消耗。

在中国银联的实际应用测试中,UCM展现出卓越性能。在"客户之声"智能客服场景下,系统响应速度提升125倍,仅用10秒就能准确识别客户诉求。银联表示将联合华为等合作伙伴,通过国家AI应用测试平台,加快金融AI解决方案的产业化落地。

为推动行业协同创新,华为宣布了UCM开源路线图。该系统采用开放式架构设计,兼容多种计算框架和硬件平台。首期代码将于9月开放,并计划逐步融入主流AI社区,共建推理计算新生态。这一举措将加速AI技术从实验研究到商业应用的转化进程。

更多文章

-

浙江科创格局焕新:企业梯队成势 创新生态跃升

当时间的指针行至2025年末,浙江的创新图景正在经历一场深刻的演化。年初,一组被称为“杭州六小龙”的科技企业崭露头角,以其突破性的技术与市场表现,拉开了这一年的序幕。它们的集体涌现与稳健成长,不仅成为年度热词,更标志着一个以高潜力科技企业为主角的发展新篇章已然开启。然而,故事并未止步于此。在虚拟现实、智

-

沪举办智能教育研讨会 共话AI推动教学创新路径

近日,上海举办了一场围绕智能技术与教育融合发展的学术会议。与会专家与教师共同探讨了如何借助新兴科技推动教学创新,构建适应数字时代的教育新环境。本次活动由多家教育研究机构、学术团体及企业联合筹办。会上,上海市教育学会负责人指出,人工智能正在深刻改变传统教学形式,推动教育向个性化和均衡化的方向发展。来自

-

制造企业理性布局人工智能 技术扎根产业求实效

当前,人工智能正从概念探讨加速融入实体经济,成为驱动制造业革新的关键力量。在氟化工行业处于领先地位的多氟多公司,较早启动了智能化转型,构建了一套涵盖数据基础、场景应用与产业融合的完整实践体系。位于河南的氟基新材料研发基地内,一面醒目的元素周期表勾勒出企业的技术布局——其产品深度关联了表上前段多个关键

-

人工智能角逐推升资金投入,全球数据枢纽布局加速扩张

标普全球最新统计指出,本年首十一月,全球范围投向数据枢纽的资金累计已接近610亿美元,超越上年总额,刷新历史纪录。行业分析指出,科技领军企业及基建开发商正全力扩充数据处理能力,以应对由智能技术发展带来的庞大运算需求。一、“当前投入仅为开端”数据显示,数据枢纽建设正进入高速扩张阶段。今年前十一月达成的上百

-

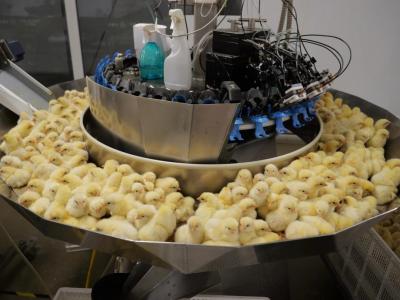

技术赋能养殖业 松桃智能养鸡助农增收

在松桃太平营街道的一家禽苗培育场内,近期一批禽苗正装箱运往外地。养殖区里,设备自动运转,环境调控系统持续监测,确保孵化条件稳定。这座现代化养殖场目前有大量种蛋处于孵化阶段,雏禽不断破壳,展现着当地养殖业的活力。自引入重点企业后,松桃蛋鸡养殖逐步走向科技化与规范管理。通过采用自动喂养、光照调节、环境监